特征提取是机器学习和数据分析中的一个过程,涉及从原始数据中识别和提取相关特征。这些特征随后用于创建更具信息量的数据集,可进一步用于各种任务,例如:

- 分类

- 预测

- 聚类

特征提取旨在降低数据复杂度(“数据维度”),同时尽可能多地保留相关信息。有助于提高机器学习算法的性能和效率,并简化分析过程。特征提取可能涉及创建新特征(“特征工程”)和数据操作,分离并简化有意义特征与不相关特征的使用。

什么是特征?

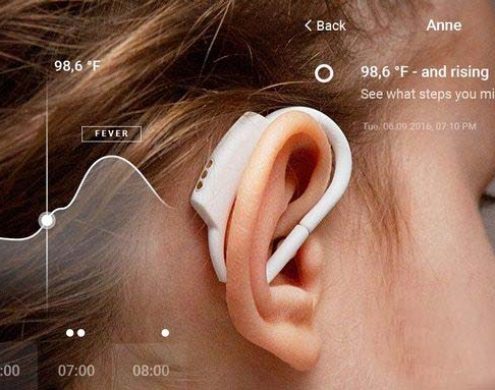

特征是记录数据集中可测量的单个属性。在机器学习和统计学中,特征通常被称为“变量”或“属性”。相关特征与模型的用例具有关联性或相关性。在患者医疗数据集中,特征可以是年龄、性别、血压、胆固醇水平以及其他与患者相关的可观察到的特征。

为什么特征提取很重要?

特征提取在许多实际应用中起着至关重要的作用。例如,图像和语音识别、预测建模以及自然语言处理 (NLP) 等过程都离不开特征提取。在这些场景中,原始数据可能包含许多不相关或冗余的特征。这使得算法难以准确地处理数据。

通过特征提取,相关特征被从不相关特征中分离出来(“提取”)。处理的特征越少,数据集就越简单,分析的准确性和效率也就越高。

常见特征类型:

数字:数值类型(int、float 等)的值。例如:年龄、薪水、身高。

类别特征:可以取有限个值的特征。例如:性别(男、女、X)、颜色(红、蓝、绿)。

序数特征:具有明确顺序的分类特征。例如:T恤尺码(S、M、L、XL)。

二元特征:分类特征的一种特殊情况,只有两个类别。例如:is_smoker(是,否)、has_subscription(真,假)。

文本特征:包含文本数据的特征。文本数据通常需要特殊的预处理步骤(例如标记化)才能将其转换为适合机器学习模型的格式。

特征归一化

由于数据特征可以在不同的尺度上进行测量,因此通常需要对其进行标准化或规范化,尤其是在使用对变量的大小和尺度敏感的算法时(例如基于梯度下降的算法、k 均值聚类或支持向量机)。

归一化是指对数据中自变量或特征的范围进行标准化。此过程可以使某些算法收敛得更快,从而提高模型性能,特别是对于那些对输入特征规模敏感的算法。

特征规范化有以下作用:

尺度敏感性:较大尺度的特征可能会对结果产生不成比例的影响。

更佳性能:标准化可以确保每个特征的贡献与最终决策大致成比例,从而提升许多机器学习模型的性能。这对于优化算法尤其重要,因为它们可以利用标准化的特征更快地实现收敛。

然而,某些特征可能需要对结果产生更大的影响。此外,归一化可能会导致一些有用信息的丢失。因此,在特征提取过程中应用归一化时要谨慎。

常见的特征提取技术

特征提取有多种技术,每种技术都针对特定类型的数据和任务。以下是特征提取的一些实际用途:

自动编码器:自动编码器可以识别关键数据特征。自动编码器的概念在于从原始数据集的编码中学习,从而获得新的、更有效的特征。它通过训练神经网络来重建输入,迫使神经网络发现并利用数据中的结构来实现这一点。通过这一过程,自动编码器可以降低数据维度并从中提取重要特征,从而构建更高效的机器学习模型。

主成分分析 (PCA):这种特征提取方法可以降低大型数据集的维数,同时保留最大信息量。主成分分析强调变化,并捕捉数据集中变量之间的重要模式和关系。

词袋模型 (BoW):词袋模型是自然语言处理 (NLP) 中的一种有效技术,可以提取文本中使用的单词(即特征),并根据其使用频率进行分类。每个文档都对应一个词计数向量。机器学习算法随后将词计数作为输入。

这种方法将文本转换为易于分析的形式。然而,也意味着它会丢失关于顺序或结构的更细微的信息。

词频-逆文档频率 (TF-IDF): TF-IDF 是 BoW 的扩展,是一种 NLP 特征提取技术,使用数值统计数据来反映某个词对文档集或语料库中某个文档的重要程度。与 BoW 相比,它不仅考虑某个词在单个文档中的频率,还考虑语料库中所有其他文档的频率,助于调整某些词通常出现频率更高的情况。

图像处理技术:图像处理技术涉及原始数据分析,以识别和分离图像中的重要特征或模式。涉及识别边缘和角落,或提取颜色、纹理和形状等特征,用于图像分类、目标检测和图像分割等任务。

微信扫描下方的二维码阅读更多精彩内容